2010年代以降、人工知能(AI)は著しい発展を遂げ、生活のあらゆるシーンを支える存在になってきています。今や家電やスマートフォンには予め搭載されており、近年では自動運転にも活用されています。しかし、AIは本当に安全なのでしょうか?2023年は、会話型のAI、チャットボットが飛躍的に進化し、人間の知能を脅かす存在になってきています。既存の職業が奪われるだけではなく、生命にまで危険にさらしかねないAIとこれからどのように付き合っていけばいいのか国際的な課題になってきました。今回は、「AIとセキュリティ」について、吉川雅弥先生にお聞きしました。

AIにまつわる4つのセキュリティの課題

AIとセキュリティを考える上で、今4つの問題点があるといわれています。1つは「AIをだます」こと。例えば、自動運転車は、搭載されたカメラが「一時停止」の標識を認識し、車が停止するようになっています。しかし、標識の一部をわずかに変更することで、私たち人間の目には「普通の」一時停止の標識に見えても、自動運転車のシステムでは認識できず、対向車などにぶつけることができるとわかってきました。

AIとセキュリティを考える上で、今4つの問題点があるといわれています。1つは「AIをだます」こと。例えば、自動運転車は、搭載されたカメラが「一時停止」の標識を認識し、車が停止するようになっています。しかし、標識の一部をわずかに変更することで、私たち人間の目には「普通の」一時停止の標識に見えても、自動運転車のシステムでは認識できず、対向車などにぶつけることができるとわかってきました。

また、自動運転車は車間距離などを測るために「測距センサ」を使います。レーザー光を照射し、物体に当たって光が戻ってくる時間で距離を測るのですが、その光に対して偽造パルスで妨害すれば計測距離を改ざんできます。AIの判断に必要な外部データの改ざんが大きな課題になってきたのです。

2つ目は、AIをサイドチャネルアタックから守ること。消費電力や電磁波、処理時間などの物理情報を使って、中の情報や暗号を推定することを「サイドチャネルアタック」といいますが、AIがある判断を下すときの消費電力や電磁波をずっと観察していると中の情報がどのようなものか推定できます。AIの中の情報が盗まれると、不正にコピーをつくれるので、これを防ぐために、中の情報と物理情報の相関を断ち切ることが求められています。

3つ目は、AIの学習データを守ること。AIが導き出した判定結果から、そのAIがどういったデータで学習したのかを推定できるといわれています。医療現場で活用されるAIは人々の病歴などのトップシークレットとも言えるプライバシーの優先度が高いデータを扱っていますから、推定されると個人情報が漏えいすることになってしまいます。そのため、どういったデータでAIが学習したのか推定できないようにする必要があります。

4つ目は、学習データを汚染させないこと。本来であれば「A」と判定するはずのAIに対して「B」という判定をさせるため、攻撃者が意図的に学習データを改ざんしてAIの判断を狂わせるという攻撃手法があります。これを「ポイズニング」といい、実際にこうした攻撃が数多く報告されています。

悪意ある攻撃者からAIを守ること

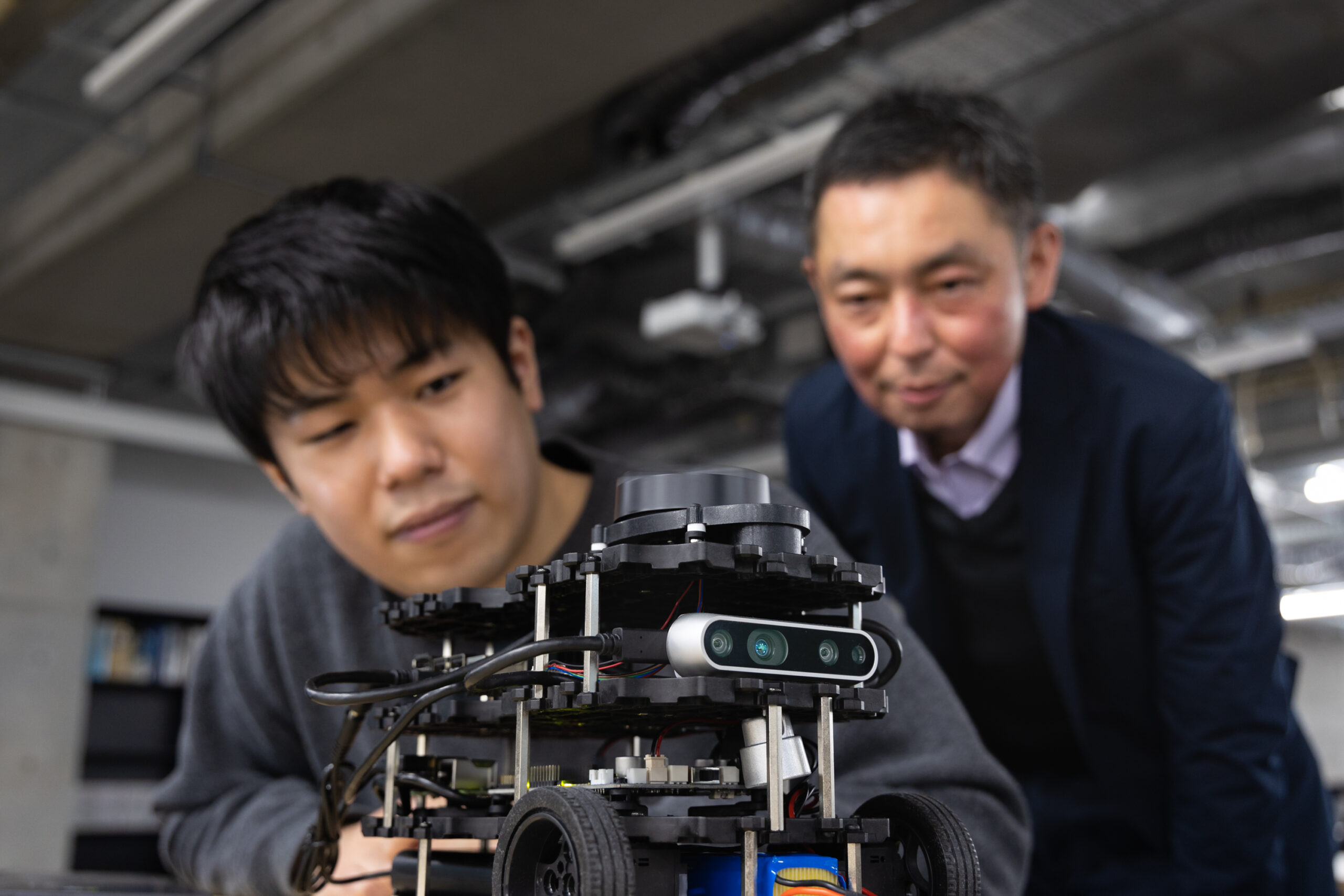

今後はあらゆる分野でさまざまな種類のAIが活用されていきます。AI×〇〇×□□といったように、複合的な分野にまたがり、さまざまな技術を組み合わせて利用されていきます。私はハードウェアのセキュリティが専門なので、最近は「AI×セキュリティ」「AI×セキュリティ×ハードウェア」といったように、自分の専門にAIを組み合わせて、「悪意ある攻撃者からいかにAIを守るのか」を研究しています。まだスタートしたばかりの分野ですが、AIを現実社会で利用するにあたっては必須の内容だと思います。

今後はあらゆる分野でさまざまな種類のAIが活用されていきます。AI×〇〇×□□といったように、複合的な分野にまたがり、さまざまな技術を組み合わせて利用されていきます。私はハードウェアのセキュリティが専門なので、最近は「AI×セキュリティ」「AI×セキュリティ×ハードウェア」といったように、自分の専門にAIを組み合わせて、「悪意ある攻撃者からいかにAIを守るのか」を研究しています。まだスタートしたばかりの分野ですが、AIを現実社会で利用するにあたっては必須の内容だと思います。

これからAIにいろいろな仕事がシフトする中で、「信用足り得るAIか」ということがますます重要になります。自動運転に使われるAIや不審者を検知する顔認証システムなどは人命に関わるものですから、何か一つでも問題が発生すると社会不安を引き起こすことになります。また、アタックを受けていることを気づかせないように、おいしい情報だけ抜き取るハッカーもいるかもしれません。

攻撃者はルール無用で、さまざまな情報を駆使してあらゆる角度から最も脆弱なところを攻撃します。セキュリティの課題は世の中の人全員が良い人にならない限りなくならないでしょう。それでも安全性を確保するために、5年、10年先の事を考えることが我々大学のミッションだと思っています。

【取材日】2021年1月22日